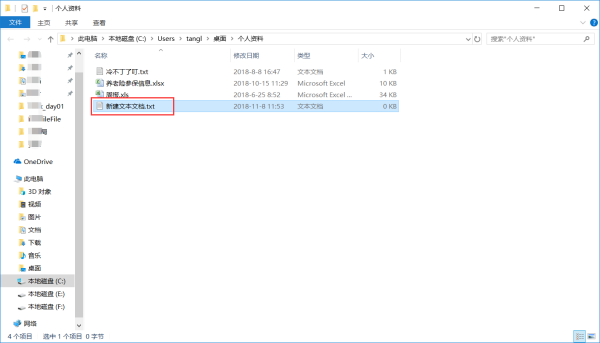

凡是的robots.txt文件的利用只需要成立一个以robots为名的txt空白内容文件即可,如许搜刮引擎就默认抓取全站。但假如您的网站内容有些隐私不希看被搜刮引擎蜘蛛抓走,那么您可就要留意一些利用技巧了。

User-agent: *

Disallow: /admin/ 后台办理文件

Disallow: /require/ 法度文件

Disallow: /attachment/ 附件

Disallow: /images/ 图片

Disallow: /data/ 数据库文件

Disallow: /template/ 模板文件

Disallow: /css/ 样式表文件

Disallow: /lang/ 编码文件

Disallow: /script/ 脚本文件

robots.txt文件里还可以直接包含在sitemap文件的链接。就像如下:

Sitemap: /sitemap.xml

User-agent:

该项的值用于描述搜刮引擎robot的名字。在"robots.txt"文件中,假如有多条User-agent记录申明有多个robot会受到"robots.txt"的**,对该文件来说,至少要有一条User-agent记录。假如该项的值设为*,则对任何robot均有效,在"robots.txt"文件中,"User-agent:*

Disallow:

该项的值用于描述不希看被拜候的一组URL,这个值可所以一条完整的路径,也可所以路径的非空前缀,以Disallow项的值开首的URL不会被robot拜候。例如"Disallow:/help"禁止robot拜候/help.html、/helpabc.html、/help/index.html,而"Disallow:/help/"则答应robot拜候/help.html、/helpabc.html,不克不及拜候/help/index.html。"Disallow:"申明答应robot拜候该网站的所有url,在"/robots.txt"文件中,至少要有一条Disallow记录。假如"/robots.txt"不存在或者为空文件,则对于所有的搜刮引擎robot,该网站都是开放的。

Allow:

该项的值用于描述希看被拜候的一组URL,与Disallow项相似,这个值可所以一条完整的路径,也可所以路径的前缀,以Allow项的值开首的URL是答应robot拜候的。例如"Allow:/hibaidu"答应robot拜候/hibaidu.htm、/hibaiducom.html、/hibaidu/com.html。一个网站的所有URL默认是Allow的,所以Allow凡是与Disallow搭配利用,实现答应拜候一部分网页同时禁止拜候其它所有URL的功能。